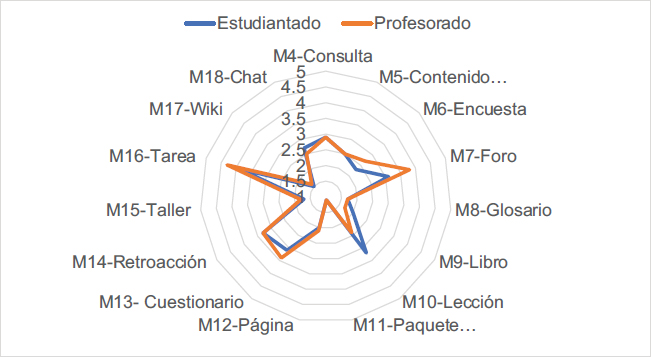

Figura 1. Frecuencia de uso de las herramientas del Campus para el desarrollo de las competencias transversales.

Laia Lluch-Molinsa (*), Elena Cano-Garcíab

a Universidad de Barcelona, Barcelona, España

https://orcid.org/0000-0002-7288-2028laia.lluch@ub.edu

b Universidad de Barcelona, Barcelona, España

https://orcid.org/0000-0003-2866-5058ecano@ub.edu

ABSTRACT

In the 2020-2021 academic year, the situation caused by the pandemic led the educational system to adopt hybrid-teaching modalities, which could settle down in post-pandemic time, adjusting those aspects that were implemented due to the unexpected change but whose pedagogical sense could be revised. A study is presented on the frequency of use, perceived usefulness, and satisfaction with the Virtual Campus (Moodle) tools of both teachers and students for assessing competencies in blended learning at the University of Barcelona. Through a questionnaire (n= 129 teachers and n= 265 students), greater teacher satisfaction with these tools is verified, and there is a high coincidence between both groups regarding their low usefulness for the development and assessment of transversal competencies. The most valuable activities (BB-Collaborate, Task, and Forum) seem valued more for their use than their real contribution to competence development. All of this has implications for future competency-based university teaching designs because taking advantage of Moodle tools to support competence development is still a challenge for the future.

Keywords

assessment; blended learning; virtual campus; digital competence; assessment literacy; COVID-19 pandemics.

RESUMEN

En el curso 2020-2021, la situación producida por la pandemia hizo que la educación superior adoptase modalidades de enseñanza híbridas que pueden consolidarse en la época post-pandemia ajustando aquellos aspectos que se implementaron por la urgencia de un cambio sobrevenido pero cuyo sentido pedagógico puede ser revisado. Se presenta un estudio en el que se analiza la satisfacción, la frecuencia de uso y la utilidad percibida de las herramientas del Campus Virtual tanto de profesorado como de estudiantado para la evaluación de competencias, en un contexto de docencia híbrida en la Universidad de Barcelona. A través de un cuestionario (n=129 profesores y n=265 estudiantes) se constata una mayor satisfacción de los docentes con esas herramientas y una alta coincidencia entre ambos colectivos respecto a su escasa utilidad para el desarrollo y la evaluación de las competencias transversales. Las actividades indicadas como más útiles (BB-Collaborate, Tarea y Foro) parecen valorarse más por su empleo que por su verdadera posible contribución al desarrollo competencial. Todo ello posee implicaciones para los futuros diseños de docencia universitaria en el marco de una educación basada en competencias, dado que aprovechar las herramientas de Moodle como apoyo al desarrollo competencial del estudiantado sigue siendo un reto de futuro.

Palabras clave

evaluación; docencia híbrida; campus virtual; competencia digital; alfabetización evaluativa; pandemia COVID-19.

La pandemia causada por el COVID-19 con el cierre repentino de todas las universidades y las condiciones de confinamiento hizo que instituciones y profesionales de las organizaciones educativas tuvieran que migrar a la docencia en línea de forma rápida (Grande-de-Prado et al., 2021), en ocasiones sin un diseño instruccional o tecno-pedagógico pensado explícitamente para la enseñanza en línea (García-Peñalvo et al., 2020). A pesar de la emergencia de la situación, gran parte del profesorado fue capaz de diseñar propuestas de aprendizaje y de evaluación en línea que, quizás, quedarán incorporadas en la docencia en la educación superior (Gillis & Krull, 2020).

En este contexto, los intereses de los docentes respecto la evaluación estuvieron básicamente centrados en e-proctoring o en las herramientas tecnológicas (Kumar, 2020), por lo que describir las herramientas empleadas puede resultar valioso. Sin embargo, la evaluación en línea debería superar la elaboración de cuestionarios y el debate sobre el cheating (Harper et al., 2020; Grande-de-Prado et al., 2021) y contribuir a crear propuestas de evaluación productivas, auténticas y competenciales (Ibarra-Sáiz et al., 2020). Por ese motivo, el presente estudio se centra en el uso de las actividades de Moodle para la evaluación de competencias.

La situación de confinamiento derivada de la COVID-19 hizo patente la necesidad de promover sistemas de evaluación soportados por la tecnología. Dichos sistemas deberían de cumplir los criterios generales que se esperan de las buenas prácticas de evaluación: estar alineados con los resultados de aprendizaje y las tareas (Biggs & Tang, 2003); promover una evaluación auténtica (Villarroel & Bruna, 2019); fomentar la participación y la progresiva autonomía del estudiantado (López-Pastor & Sicilia-Camacho, 2017); y, en definitiva, estar al servicio de la promoción del aprendizaje, teniendo un propósito formativo (Winstone & Boud, 2019). Pero, además, las propuestas de evaluación en línea deben cumplir unos criterios específicos (JISC, 2022): (a) ayudar a los estudiantes a entender los criterios de calidad de las tareas que deben realizar autónomamente o en equipo; (b) apoyar las necesidades personalizadas de los alumnos; (c) generar una comunidad de aprendizaje que mantenga la motivación y el engagement o (d) gestionar la carga de trabajo del estudiantado y del profesorado de forma eficaz. Sin embargo, hasta el momento, la contribución de las tecnologías parece haberse centrado más en la (d), la gestión de datos, la automatización de calificaciones y la mejora de la carga de trabajo del profesorado (Bhagat & Spector, 2017).

No tan usual (a) brindar oportunidades para que los estudiantes se involucren activamente con los criterios para el aprendizaje (Baughan, 2020) desarrollando así su capacidad para regular su aprendizaje y mejorar su rendimiento. Tampoco parece tan desarrollado, más allá de algunas propuestas adaptativas (Molenaar et al., 2019), (b) el modo en que la tecnología puede brindar apoyos específicos. Kruiper et al. (2022) constatan la necesidad tanto ajustar los soportes para andamiar el aprendizaje de todos y todas con apoyo de la tecnología, como capacitar al profesorado para realizar un uso verdaderamente formativo de la evaluación. La (c) creación de comunidades de aprendizaje auto-motivadas sigue siendo otro de los retos (McLean, 2018) de modo que se produzca una construcción de conexiones y colaboraciones aprovechando los flujos de información que hay en las redes y basada en el intercambio de recursos entre personas (Gros, 2018).

Frente a estos retos, los entornos virtuales o sistemas de gestión del aprendizaje (LMS, en adelante, del inglés Learning Management System), como la plataforma Moodle pueden no solo constituir un repositorio de recursos en línea sino favorcer la experiencia de aprendizaje (Grande-de-Prado et al., 2021); la comunicación profesorado-estudiantado y del estudiantado entre sí (Gros, 2018); la creación de comunidades de aprendizaje (Ross, 2019); y la autorregulación del aprendizaje, con un andamiaje inverso en los procesos de evaluación (Kruiper et al., 2022).

A pesar de ello, el uso de los LMS quizás diste de este potencial. Moodle es el LMS más popular según las revisiones realizadas por Altinpulluk and Kesim (2021) y Gamage et al. (2022). Gran parte de la literatura referida a evaluación en el marco de Moodle explora los resultados de experiencias realizadas con cuestionarios o quizzes (Schweighofer et al., 2019). De hecho, las posibilidades de los cuestionarios tanto para la evaluación diagnóstica (Maier et al., 2016) como para un uso formativo (Poth, 2018) han sido sobradamente exploradas, pero aún parece que no se han generalizado y se sigue insistiendo en un uso sumativo y, por tanto, en el modo en que se aplican para evitar el cheating (Noorbehbahani et al., 2022), desaprovechando el potencial de las actividades de aprendizaje, que son en sí mismas actividades evaluables (Heitink et al., 2016).

Así, por ejemplo, el foro puede ser útil para discutir e incluso consensuar los criterios de evaluación, fomentando la actividad reflexiva tendente al aumento del juicio evaluativo (Pinto & Leite, 2020). A su vez, las wikis pueden constituir espacios de apoyo al aprendizaje basado en proyectos (Mellar et al., 2018) y para construir y evaluar colectivamente conocimiento compartido (Bennet et al., 2017). La actividad denominada Tarea o Archivo puede también tener un propósito formativo si se programa la posibilidad de realizar diversas entregas como consecuencia del feedback, puesto que lo importante son los loops o ciclos de feedback que integren mejoras progresivamente (Carless & Boud, 2018). Lo mismo sucede con el resto de las actividades: la lección, que permite establecer secuencias o itinerarios, y el taller, que promueve la evaluación entre iguales a partir de una rúbrica o de unos criterios (aspectos) a valorar. Ambos pueden contribuir al desarrollo de las competencias transversales (Balderas et al., 2018). Por lo tanto, las herramientas del campus poseen potencialidades cuya explotación depende de que tanto el profesorado como el estudiantado posea la suficiente alfabetización digital (Pinto & Leite, 2020) —entendida esta como capacidad de una persona para realizar diferentes tareas en un ambiente digital (localizar, organizar, entender, evaluar y analizar información utilizando tecnología digital)— y la suficiente competencia evaluativa (Casal Otero & García Antelo, 2018; Winstone et al., 2017). Sin embargo, a pesar de que las plataformas institucionales parecen haber sido las más empleadas para vehicular los procesos de aprendizaje y la interacción entre los estudiantes, no parecen haber aprovechado su potencial transformador, produciéndose una simple introducción o agregaración de las tecnologías a procesos tradicionales (León-Gómez et al., 2021).

En el marco de los diseños basados en competencias, las actividades de evaluación deberán estar alineadas no solo con los resultados de aprendizaje (Biggs & Tang, 2003) sino también con las competencias a promover (Gulikers et al., 2010), lo cual es importante porque la COVID-19 subrayó la relevancia de las competencias transversales (Joia & Lorenzo, 2021), que son aquellas comunes a todos los estudiantes de una misma Universidad o centro universitario, independientemente del título que cursen (pensamiento crítico, comunicación, trabajo en equipo, etc.). Sin embargo, el desarrollo y evaluación de competencias se hace más compleja en un entorno en línea (UNESCO, 2020).

La evaluación de competencias se caracteriza por ser una evaluación auténtica y situada, de modo que propone actividades: (a) realistas, diseñadas desde una lógica no exclusivamente académica sino también de la futura práctica profesional (Gulikers et al., 2010); (b) aplicadas, en las que el estudiantado debe seleccionar y aplicar los saberes que posee para resolver una situación, tomar una decisión o dar una respuesta (Cañadas, 2020); (c) complejas, con cierto volumen de trabajo y que suelen poseer diversas vías de resolución (Cano, 2019) y (d) reflexivas, de modo que acompañan la resolución de un problema con la capacidad de justificar la selección de los procedimientos y procesos así como de las consecuencias esperadas (Villa, 2020). Este tipo de tareas de aprendizaje y de evaluación competenciales requieren del rol activo del estudiante y de su interacción con contenidos, con otros estudiantes y con profesionales (Sáiz-Manzanares et al., 2022).

Los LMS pueden constituir entornos para la interacción, donde se integren simulaciones, casos, proyectos o problemas y se facilite la interacción para una resolución exitosa. En paralelo pueden ofrecer tanto los sistemas de registro de la evolución y el alcance del desarrollo competencial (con escalas específicas, si se desea, para la calificación de las competencias), como sistemas de apoyo a la progresión (con el PLD-Personalized Learning Design, las alertas, las lecciones o las actividades condicionadas). Por todo ello, parece relevante explorar el empleo que se ha dado a las herramientas para la evaluación en un Campus virtual Moodle durante el periodo de pandemia, así como la percepción de su utilidad para lograr las competencias con el fin de obtener resultados que permitan orientar futuros diseños curriculares online y/o blended.

Se explora, mediante una investigación descriptiva, la opinión de profesorado y estudiantado respecto a prácticas de evaluación que promueven el desarrollo de competencias transversales y su evaluación. En concreto se plantean 4 objetivos:

• O1: Conocer el grado de satisfacción global con las herramientas informáticas utilizadas para evaluar las competencias, en periodo de docencia mixta.

• O2: Comparar la percepción de estudiantado y profesorado respecto a la frecuencia de uso de las herramientas informáticas del Campus (plataforma Moodle), en contexto de docencia mixta para evaluar.

• O3: Comparar la percepción de estudiantado y profesorado respecto al grado de utilidad de las herramientas informáticas del Campus (plataforma Moodle) para la evaluación de competencias, en contexto de docencia mixta para evaluar.

• O4: Comparar la frecuencia de uso y el grado de utilidad otorgado a las herramientas informáticas del Campus según la percepción del estudiantado y profesorado (O2-O3).

Se ha considerado necesario disponer de datos sobre las diversas áreas de conocimiento que tiene la Universidad de Barcelona, dado que los diversos campos de conocimiento pueden poseer estrategias e instrumentos de evaluación propios (De Miguel, 2008; Cano & Ion, 2012). Con ello, y para garantizar la viabilidad de la investigación, el equipo investigador integra miembros de diversas facultades de la Universidad de Barcelona: Derecho, Farmacia, Matemáticas, Historia, Información y Comunicación Audiovisual, Psicología y Educación.

La obtención de información para este trabajo se ha realizado mediante el procedimiento de encuesta anónima y en línea, a través de un cuestionario estructurado autoadministrado, desarrollado en el marco del proyecto “Análisis de las prácticas de evaluación en entornos de docencia mixta orientadas al desarrollo de las competencias transversales” (REDICE20-2083), a partir de la literatura previa. Este instrumento se compone de una serie de preguntas cerradas con respuestas a puntuar en una escala tipo Likert de 1 a 5 puntos (a la que se ha añadido el rango No sabe/No contesta). Además, el cuestionario incluye una pregunta cerrada de opción múltiple para recoger la opinión de los encuestados sobre la utilidad de las herramientas de la versión 3.11 de Moodle para el desarrollo de las seis competencias transversales establecidas por la Universitat de Barcelona (2008): compromiso ético (C1), capacidad de aprendizaje (C2), trabajo en equipo (C3), capacidad creativa (C4), sostenibilidad (C5) y capacidad comunicativa (C6). Con esta pregunta se solicitó a los encuestados que seleccionasen la o las competencias transversales (C1 a C6) que, en su opinión, podían ser evaluadas mediante cada una de las herramientas del Moodle (M1 a M18) (ver Tablas 3 y 4).

Para proceder a su validación, en primer lugar, el cuestionario se sometió a un panel interjueces por parte de miembros del equipo seleccionados en base al criterio de especialización en el campo de conocimiento. El cuestionario fue validado por los expertos mediante un formulario creado ad hoc para pronunciarse acerca de su inteligibilidad, pertinencia y relevancia. Por otra parte, los expertos aportaron sugerencias cualitativas para su mejora En consecuencia, el cuestionario fue ajustado siguiendo sus observaciones y comentarios mayoritariamente para reemplazar o especificar y ampliar la información relativa a las cuestiones e ítems. En segundo lugar, en relación al proceso de validación cuantitativa, se calculó el Alpha de Cronbach después de administrar el cuestionario y este fue aceptable con un valor de 0.732 para los ítems analizados.

Se habilitó el cuestionario en Google Forms con una versión para el estudiantado y otra adaptada para el profesorado, durante el mes de marzo 2021, el cual fue enviado a toda la población desde el Vicerrectorado de la Universidad de Barcelona. Respondieron un total de 265 alumnos/as y 129 profesores/as. Las características de estas muestras se presentan en la Tabla 1.

Tabla 1. Descripción de las muestras de estudiantado y profesorado.

Estudiantado |

Profesorado |

||||

Estudios/Grados |

Nº |

% |

Facultad |

Nº |

% |

Matemáticas |

70 |

26.4 |

Matemáticas |

11 |

8.5 |

Educación Primaria |

51 |

19.2 |

Educación |

43 |

33.3 |

Farmacia |

48 |

18.1 |

Farmacia |

19 |

14.7 |

Psicología |

8 |

3.0 |

Psicología |

21 |

16.3 |

Arqueología |

25 |

9.4 |

Historia y Geografía |

20 |

15.5 |

Gestión y Administración Pub. |

21 |

7.9 |

Derecho |

9 |

7.0 |

Informática |

28 |

10.6 |

Información y Medios Audiovisuales |

6 |

4.7 |

Comunicación audiovisual |

14 |

5.3 |

|||

Los datos cuantitativos recogidos se han analizado con el paquete informático IBM SPSS Statistics 27 y GraphPad Prism. En un primer momento, se realizó una exploración descriptiva de los datos para ver cómo se comportaban (distribución de la muestra...) y cómo se distribuían los resultados (mínimo, máximo, media, mediana, desviación típica). A posteriori, se realizó un análisis de comparación de medias para datos no apareados por tratamiento paramétrico (test t de Student), tras comprobar la distribución normal de los datos, para observar si existían diferencias significativas entre la percepción del estudiantado y profesorado.

Seguidamente, se presentan los resultados desglosados por objetivos de estudio. Se muestra la puntuación mínima (Min.) y máxima (Máx.) sobre 5, Nº de respuestas de tipo No Sabe/No Contesta (NS), valor de la mediana (Me), media (M) y desviación típica (DT). Resultados del test t-Student (valor de p).

En cuanto a la opinión del estudiantado y profesorado sobre el objetivo O1 “Grado de satisfacción global con las herramientas informáticas en entornos de docencia mixta”, se observa en la Tabla 2 que las puntuaciones atribuidas por el estudiantado con un valor medio de (3.0±1.1) y de (3.3±0.9) por el profesorado están ambas en el rango intermedio.

Tabla 2. Datos descriptivos acerca del grado de satisfacción global con las herramientas informáticas utilizadas para evaluar las competencias en periodo de docencia mixta.

Ítem |

Estudiantado |

Profesorado |

||||||||||

|

Mín. |

Máx. |

NS |

Me |

M |

DT |

Mín. |

Máx. |

NS |

Me |

M |

DT |

|

1 |

5 |

0 |

3.0 |

3.0 |

1.1 |

1 |

5 |

0 |

3.0 |

3.3 |

0.9 |

A pesar de la satisfacción globalmente positiva de ambos colectivos, el test de Student indica que las diferencias entre ambos grupos son estadísticamente significativas (p = 0.0041), lo que significa una mayor satisfacción de los docentes.

Respecto al objetivo O2 “Frecuencia de uso de las herramientas informáticas del Campus, en contexto de docencia mixta para evaluar”, se analizaron las herramientas siguientes (Tabla 3):

Tabla 3. Herramientas del Campus Virtual analizado.

Herramienta |

Utilidad |

Asistencia |

Permite a un profesor/a tomar nota de la asistencia en las clases y los estudiantes les permite su propio registro de asistencia. |

Base de datos |

Permite a los participantes crear, mantener y buscar una colección de entradas (registros). Sirve, por ejemplo, para la colección colaborativa de enlaces web, libros, etc. |

BB-Collaborate |

Permite realizar videollamadas. |

Consulta |

Permite al profesor/a plantear una pregunta y especificar un conjunto de posibles respuestas a elegir, haciendo encuestas o tomando decisiones rápidas. |

Contenido interactivo H5P |

H5P es la abreviatura de paquete HTML5: contenido interactivo tales como presentaciones, vídeos u otros elementos multimedia, preguntas, cuestionarios, juegos y más. |

Encuesta |

Proporciona encuestas ya verificadas que se han considerado útiles para determinar y estimular el aprendizaje en entornos online. |

Foro |

Permite que los participantes mantengan debates asíncronos, es decir, debates que se extienden durante un período de tiempo largo. |

Glosario |

Permite a los participantes crear y mantener una lista de definiciones como un diccionario, o recoger y organizar los recursos o la información. |

Libro |

Permite al profesor/a crear un recurso de varias páginas en un formato de libro, con capítulos y secciones. Pueden contener archivos multimedia, así como textos largos divisibles. |

Lección |

Permite ofrecer materia y/o actividades prácticas de formas diversas y flexibles creando, por ejemplo, un conjunto lineal de páginas de contenidos o actividades pedagógicas que ofrezcan distintas opciones o caminos al estudiante. |

Paquete SCORM |

Conjunto de archivos empaquetados según un estándar consensuado de objetos de aprendizaje. El contenido se muestra en varias páginas con navegación entre sí. |

Página |

Permite que el profesor/a cree un recurso de página web utilizando el editor de texto. Una página puede mostrar texto, imágenes, sonido, vídeo, enlaces web y códigos incrustados. |

Cuestionario |

Permite al profesor/a crear cuestionarios con preguntas de diversos tipos, tales como opción múltiple, verdadero/falso, emparejamiento, respuesta breve y numéricas. A su vez, el módulo Cuestionario permite recopilar datos de los usuarios. |

Retroacción |

Permite al profesor/a crear una encuesta personalizada para recoger la retroalimentación de los participantes utilizando distintos tipos de preguntas que incluyen opciones múltiples, de sí/no o de introducción de texto. |

Taller |

Permite la recogida, análisis y evaluación entre iguales del trabajo de los estudiantes. |

Tarea |

Permite comunicar las instrucciones, recoger los trabajos y proporcionar calificaciones y retroacción. |

Wiki |

Permite a los participantes añadir y editar una colección de páginas web. Un wiki puede ser de colaboración, donde todos tienen la posibilidad de editar, o individual, donde cada uno tiene su propio wiki que sólo él/ella puede editar. |

Chat |

Permite que los participantes mantengan una conversación escrita sincrónica, en tiempo real. |

Como se aprecia en la Tabla 4, existe una buena concordancia en las percepciones del estudiantado y del profesorado en una gran parte de los ítems, tan solo 5 ítems dan lugar a p <0.05.

Tabla 4. Datos descriptivos sobre la frecuencia de uso de las herramientas del Campus para evaluar.

Herramienta |

Estudiantado |

Profesorado |

|

||||||||||

|

Mín. |

Máx. |

NS |

Me |

M |

DT |

Mín. |

Máx. |

NS |

Me |

M |

DT |

t-test p valor |

M1-Asistencia |

1.0 |

5.0 |

22 |

2.0 |

2.2 |

1.3 |

1.0 |

5.0 |

5 |

2.0 |

2.2 |

1.4 |

0.8898 |

M2-Base de Datos |

1.0 |

5.0 |

45 |

2.0 |

2.1 |

1.3 |

1.0 |

5.0 |

8 |

1.0 |

1.9 |

1.3 |

0.1263 |

M3-BB-Collaborate |

1.0 |

5.0 |

4 |

5.0 |

4.4 |

0.9 |

1.0 |

5.0 |

2 |

5.0 |

4.6 |

1.0 |

0.1073 |

M4-Consulta |

1.0 |

5.0 |

16 |

3.0 |

2.9 |

1.2 |

1.0 |

5.0 |

7 |

3.0 |

2.9 |

1.6 |

0.6806 |

M5-Contenido interactivo |

1.0 |

5.0 |

10 |

2.0 |

2.5 |

1.2 |

1.0 |

5.0 |

9 |

2.0 |

2.5 |

1.5 |

1.0 |

M6-Encuesta |

1.0 |

5.0 |

9 |

2.0 |

2.3 |

1.1 |

1.0 |

5.0 |

2 |

3.0 |

2.7 |

1.4 |

0.0019 |

M7-Foro |

1.0 |

5.0 |

3 |

3.0 |

3.1 |

1.2 |

1.0 |

5.0 |

1 |

4.0 |

3.8 |

1.5 |

<0.0001 |

M8-Glosario |

1.0 |

5.0 |

31 |

1.0 |

1.7 |

1.0 |

1.0 |

5.0 |

7 |

1.0 |

1.7 |

1.1 |

0.928 |

M9-Libro |

1.0 |

5.0 |

21 |

2.0 |

2.0 |

1.1 |

1.0 |

5.0 |

7 |

1.0 |

1.7 |

1.2 |

0.0353 |

M10-Lección |

1.0 |

5.0 |

23 |

3.0 |

3.2 |

1.4 |

1.0 |

5.0 |

6 |

1.0 |

2.4 |

1.7 |

<0.0001 |

M11-Paquete SCORM |

1.0 |

5.0 |

90 |

1.0 |

1.1 |

0.5 |

1.0 |

5.0 |

16 |

1.0 |

1.1 |

0.6 |

0.7271 |

M12-Página |

1.0 |

5.0 |

61 |

2.0 |

2.0 |

1.2 |

1.0 |

5.0 |

15 |

1.0 |

2.1 |

1.5 |

0.4843 |

M13- Cuestionario |

1.0 |

5.0 |

6 |

3.0 |

3.1 |

1.2 |

1.0 |

5.0 |

4 |

4.0 |

3.4 |

1.5 |

0.0775 |

M14-Retroacción |

1.0 |

5.0 |

20 |

3.0 |

3.3 |

1.3 |

1.0 |

5.0 |

14 |

4.0 |

3.3 |

1.7 |

0.8956 |

M15-Taller |

1.0 |

5.0 |

42 |

1.0 |

1.7 |

1.1 |

1.0 |

5.0 |

8 |

1.0 |

1.8 |

1.3 |

0.34 |

M16-Tarea |

1.0 |

5.0 |

10 |

4.0 |

3.9 |

1.2 |

1.0 |

5.0 |

7 |

5.0 |

4.3 |

1.1 |

0.0008 |

M17-Wiki |

1.0 |

5.0 |

46 |

1.0 |

1.5 |

0.9 |

1.0 |

5.0 |

8 |

1.0 |

1.6 |

1.1 |

0.313 |

M18-Chat |

1.0 |

5.0 |

16 |

2.0 |

2.7 |

1.4 |

1.0 |

5.0 |

10 |

2.0 |

2.5 |

1.6 |

0.1561 |

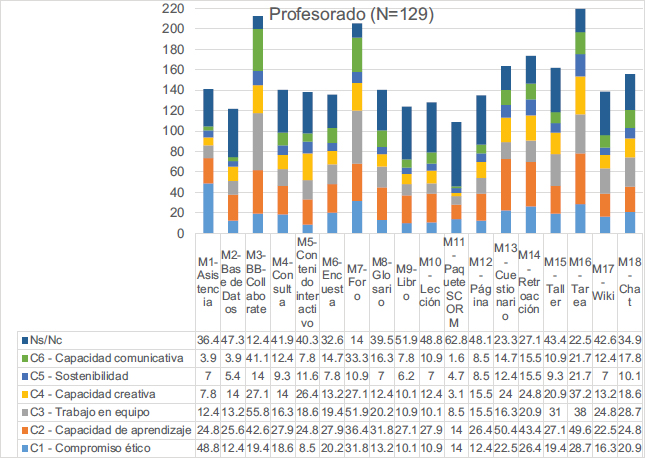

Observando la media de frecuencia de uso de ambos colectivos (Figura 1), a diferencia de los estudiantes, los docentes opinan que hacen un mayor uso de las herramientas Tarea, Encuesta, Cuestionario y Foro y, en cambio, un menor uso de Libro y Lección del Moodle.

Figura 1. Frecuencia de uso de las herramientas del Campus para el desarrollo de las competencias transversales.

Sin embargo, ambos colectivos destacan como herramientas más empleadas: BB-Collaborate (4.4 según el estudiantado y 4.6 según el profesorado) y Tarea (3.9 y 4.3). Además, equivalente a un uso moderado (medias ≥ a 3.0) se encuentran respectivamente: Retroacción (3.3 y 3.3), Cuestionario (3.1 y 3.4), Foro (3.1 y 3.8), y Lección (3.2 y 2.4). Señalan también como uso de moderado a bajo (medias 2.0-3.0): Asistencia (2.2 y 2.2), Consulta (2.9 y 2.9), Contenido interactivo (2.5 y 2.5), Encuesta (2.3 y 2.7), Página (2.0 y 2.1), Chat (2.7 y 2.5) y Base de datos (2.1 y 1.9). Finalmente, entre las menos empleadas (media < 2.0) se encuentran: Glosario (1.7 y 1.7), Paquete SCORM (1.1 y 1.1), Taller (1.7 y 1.8) y Wiki (1.5 y 1.6).

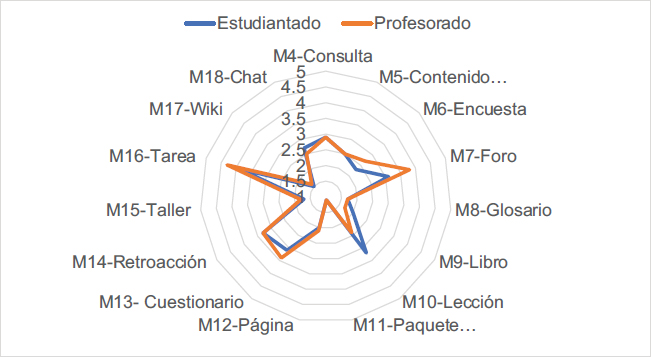

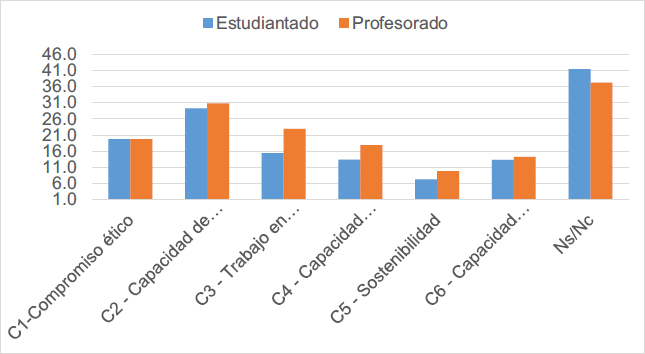

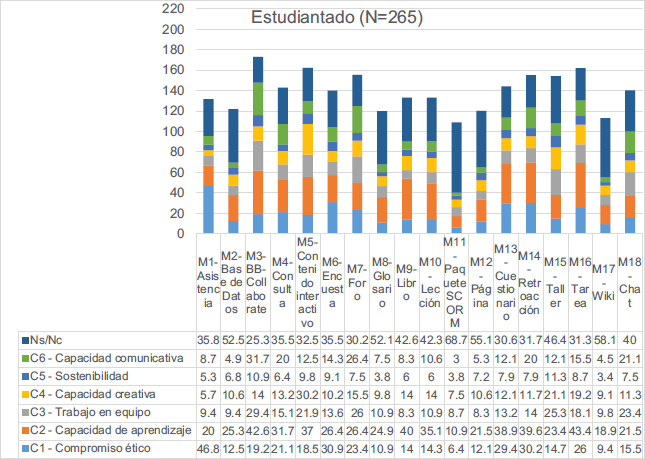

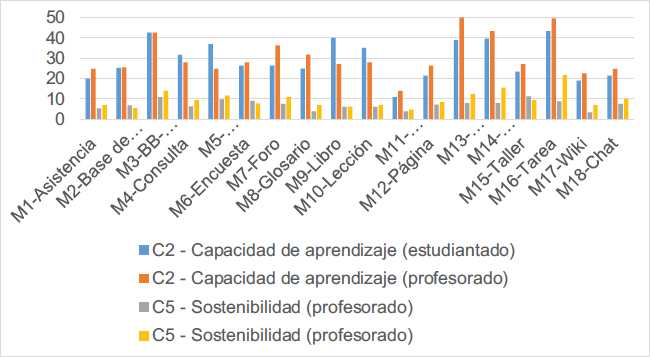

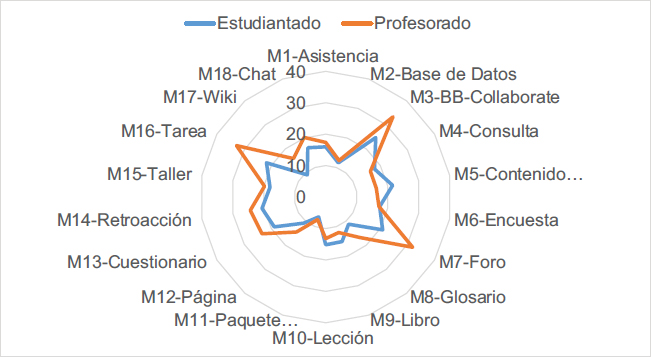

Respecto al objetivo O3 “Utilidad de las herramientas del Campus en contextos de docencia mixta para evaluar”, se perciben diferencias respecto a las 6 competencias transversales (Figura 2) y según el colectivo (Figura 3 y Figura 4). En general los valores medios globales correspondientes a cada competencia son más altos por parte del colectivo del profesorado.

Figura 2. Utilidad de las herramientas del Campus para evaluar las competencias transversales.

Figura 3. Utilidad de las herramientas del Campus para evaluar las competencias transversales (estudiantado).

Figura 4. Utilidad de las herramientas del Campus para evaluar las competencias transversales (profesorado).

Los datos aportan, también, un alto porcentaje del profesorado y alumnado (37.2% y 41.5%) que ha contestado con la respuesta Ns/Nc, aunque no sucede tanto al referirse a capacidad de aprendizaje y a compromiso ético (ver Figura 3 y Figura 4).

Se aprecia (Figura 5) que las herramientas del Moodle resultan poco útiles para el desarrollo de la Sostenibilidad (C5) (7.2% y 9.7%), la cual parece evaluarse solo vía Tarea (21.7%) y la Capacidad comunicativa (C6) (13.3% y 14.2%). En cambio, son particularmente útiles para el desarrollo de la Capacidad de aprendizaje (C2) (29.3% y 30.8%). Esta ha sido vinculada con las herramientas siguientes: Tarea (43.4% y 49.6%), Cuestionario (38.9% y 50.4%), BB-Collaborate (42.6% según ambos colectivos) y Retroacción (39.6% y 43.4%).

Figura 5. Utilidad de las herramientas del Campus para evaluar la C5-Sostenibilidad y la C2-Capacidad de aprendizaje.

Por otra parte, ambos grupos opinan que las tres herramientas que aportan mayores posibilidades en términos de desarrollo y evaluación de competencias (véase Tabla 5 y Figura 6) son BB-Collaborate (M3), Foro (M7) y Tarea (M16) seguidos de Cuestionario y Retroacción. Por el contrario, Base de datos, Glosario, Paquete SCORM, Páginas y Taller, parecen menos útiles, posiblemente por desconocimiento dado el menor uso observado de las mismas.

Se aprecia en la Tabla 5 diferencias estadísticamente significativas en las percepciones de ambos colectivos, con 13 ítems que dan lugar a p < 0.05.

Tabla 5. Percepción de utilidad de las herramientas del Campus para el desarrollo de las competencias transversales.

Estrategia de evaluación |

Estudiantado |

Profesorado |

|

||

|

M |

DT |

M |

DT |

t-test p valor |

M1-Asistencia |

16.0 |

16.0 |

17.4 |

17.0 |

0.4032 |

M2-Base de Datos |

11.6 |

7.2 |

12.4 |

7.7 |

0.2964 |

M3-BB-Collaborate |

24.7 |

12.1 |

33.3 |

15.9 |

<0.0001 |

M4-Consulta |

17.9 |

8.6 |

16.4 |

6.5 |

0.0775 |

M5-Contenido interactivo |

21.6 |

10.4 |

16.3 |

8.2 |

<0.0001 |

M6-Encuesta |

17.4 |

9.1 |

17.2 |

6.9 |

0.7908 |

M7-Foro |

20.9 |

7.8 |

31.9 |

13.3 |

<0.0001 |

M8-Glosario |

11.3 |

7.2 |

16.8 |

8.5 |

<0.0001 |

M9-Libro |

15.1 |

12.6 |

12.0 |

7.6 |

0.0113 |

M10-Lección |

15.2 |

10.2 |

13.2 |

7.4 |

0.0504 |

M11-Paquete SCORM |

6.7 |

3.0 |

7.6 |

5.4 |

0.0365 |

M12-Página |

10.8 |

5.8 |

14.5 |

6.6 |

<0.0001 |

M13-Cuestionario |

18.9 |

12.3 |

23.4 |

14.0 |

0.0013 |

M14-Retroacción |

20.6 |

12.2 |

24.4 |

10.4 |

0.0021 |

M15-Taller |

18.0 |

6.0 |

19.8 |

8.6 |

0.0181 |

M16-Tarea |

21.8 |

12.0 |

32.8 |

10.9 |

<0.0001 |

M17-Wiki |

9.2 |

5.5 |

16.0 |

6.7 |

<0.0001 |

M18-Chat |

16.7 |

6.4 |

20.2 |

6.4 |

<0.0001 |

Se percibe (Figura 6) que estas herramientas permiten desarrollar, en mayor o menor grado, las diferentes competencias genéricas, a excepción del paquete SCORM, que es la menos conocida (62.8% del alumnado y 68.7% del profesorado responde Ns/Nc) y una de las menos empleadas.

Figura 6. Utilidad de las herramientas del Campus para evaluar las competencias transversales.

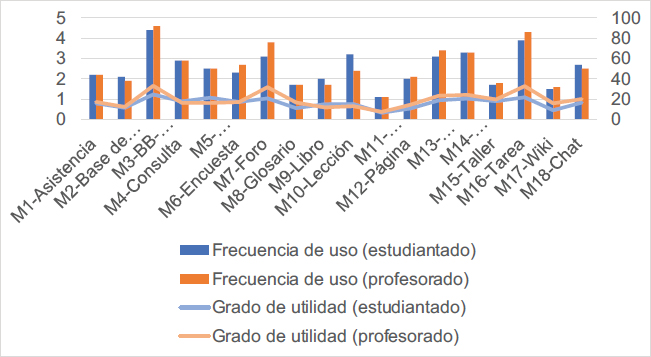

A todas las herramientas se les ha otorgado más uso que utilidad. Concretamente, BB-Collaborate, Consulta, Foro, Lección, Cuestionario, Retroacción y Tarea poseen un balance de percepción utilidad/uso negativo. Por ejemplo, BB-Collaborate utilizada en un grado de 4.6 por parte del profesorado de una escala valorada con un 3.3.

Figura 7. Comparativa de la frecuencia de uso (%) y el grado de utilidad (líneas) de las herramientas del Campus para evaluar las competencias transversales.

Este trabajo describe el empleo y utilidad percibida de herramientas digitales para la evaluación de competencias en contextos de docencia híbrida, constatando ciertas diferencias de percepción entre estudiantado y profesorado y permitiendo identificar algunas dificultades y retos de futuro.

En primer lugar, respecto al objetivo primero, al parecer el empleo de dichas herramientas ha reportado un mayor grado de satisfacción al profesorado que al estudiantado. No existen apenas estudios que hayan contrastado la satisfacción de ambos colectivos con la evaluación durante el confinamiento. Sí hay numerosos estudios sobre la satisfacción de los estudiantes con la docencia en línea, que reportan que los estudiantes estuvieron notablemente e incluso muy satisfechos (Sáiz-Manzanares et al., 2022) y que vinculan la satisfacción a la innovación didáctica percibida asociada al empleo de recursos en línea, a la motivación auto-percibida o al aumento de disponibilidad de tiempo y recursos para el trabajo autónomo (Hettiarachchi et al., 2021). Mientras que, en el caso de los estudiantes, la satisfacción parece explicarse por factores como la tecnología empleada, la flexibilidad y el tiempo proporcionados y las posibilidades de interacción (Maldonado & Vega, 2015), en el caso del profesorado, las condiciones institucionales y la formación parecen ser determinantes para explicar la satisfacción, que parece ser menor que la de los estudiantes, por lo que nuestros hallazgos, que van en la línea contraria, requerirían de mayor profundidad para comprender los motivos que han llevado a la mayor satisfacción docente (Elshami et al., 2021).

En segundo lugar, respecto a los objetivos segundo, tercero y cuarto, las funcionalidades de Moodle más empleadas fueron BB-Collaborate y la Tarea. Además, son las que, a juicio del profesorado, suponen un mayor aporte al desarrollo de competencias transversales junto con el foro. El hecho de que las herramientas más valoradas para la evaluación de competencias sean precisamente las más empleadas puede deberse al mero desconocimiento y a una falta de alfabetización digital (Abduh, 2021; Pinto & Leite, 2020). Se detecta, además, una escasa experiencia con ciertas herramientas, en particular de los Paquetes SCORM, Base de datos, Foro, Glosario, Página y Taller. Esto es ratificado por el estudiantado, quien coincide en esta percepción. En este sentido, Mirza (2021) ya ha insistido en la necesidad de formación para aprovechar el potencial de las herramientas al alcance.

En tercer lugar, no parece existir una relación sólida entre las actividades de evaluación digitales proporcionadas por Moodle y el desarrollo de competencias transversales, aunque BB-Collaborate, la Tarea y el Foro parecen ser, como se ha indicado, las más cercanas a dichas competencias. Es importante destacar el alto porcentaje de respuestas situadas en el “No sabe/No contesta” (41.4% del estudiantado y 37.2% del profesorado), que denotan un gran desconocimiento.

En cualquier caso, se perciben ciertas tendencias como que la competencia de compromiso ético está relacionada, tanto para profesorado como para alumnado con la “Asistencia". Se intuye que al responder este ítem ambos colectivos han tomado el término asistencia de forma genérica y no como herramienta de Moodle, puesto que se trata de una funcionalidad que no se ha empleado masivamente. Lo mismo sucede con la “Retroacción”. Por otra parte, la competencia comunicativa está más asociada a la tarea (supuestamente con relación a la comunicación escrita) y al BB-Collaborate (con relación a la comunicación oral), aunque los datos parecen mostrar un empleo más unidireccional para mantener las sesiones expositivas pre-pandemia por parte del profesorado que un uso como espacio que pudiera ser útil para la comunicación profesorado-alumnado y para la interacción del alumnado entre sí (León-Gómez et al., 2021). También existe una cierta asociación entre la competencia de trabajo en equipo y el BB-Collaborate, el chat o el foro como espacios para la construcción colectiva, que podrían fortalecerse en el futuro si se mantienen modalidades híbridas (Llorente et al., 2022).

Especialmente relevante es que, en concreto la competencia vinculada con la capacidad de aprendizaje ha sido la más asociada a las herramientas empleadas, mientras que la capacidad comunicativa y, en especial, la sostenibilidad parece ser las que menos se pueden promover con dichas herramientas. Ulteriores estudios se requerirían para profundizar en los motivos de esta escasa consideración, pero podría avanzarse que los resultados están en sintonía con la escasa presencia de la sostenibilidad en los planes de estudio (Miranda et al., 2021).

El hecho de que la competencia de aprendizaje y responsabilidad, que, en el documento de competencias transversales de la Universidad de Barcelona, incluye el aprender a aprender, haya sido asociada a todas las herramientas parece indicar una visión superficial o ingenua de lo que supone esta competencia. Parecería inferirse que, por el hecho de estudiar para un examen o realizar una tarea, el estudiantado aprende a aprender. Esta visión se contrapone a la necesidad de una planificación explícita de dicha competencia (Torrano Montalvo & González Torres, 2017), su inclusión en el mapa de competencias de la titulación y su desarrollo sistemático e intencional que facilite un andamiaje para su consecución (Gargallo-López et al., 2020). Este resultado enlaza con la actual reclamación respecto a la necesidad de mejorar la agencia de los estudiantes en sus procesos de aprendizaje y prácticas de evaluación (Lluch et al., 2021; Vaganova et al., 2020; Winstone et al., 2017) analizan el empleo de las herramientas de Moodle para la evaluación y muestran cómo un abanico de posibles actividades (foro, entrega de tareas, wikis, etc.) pueden ser también relevantes para la evaluación y, particularmente, para la evaluación y el feedback en los que el estudiantado posee un rol protagonista (Baughan, 2020).

Las herramientas más valoradas no siempre son las más empleadas posiblemente debido a la falta de conocimiento de otras actividades para su puesta en práctica. Ello nos conduce a dos reflexiones que pudieran facilitar el empleo exitoso de un LMS. Por una parte, las tareas y el BB-Collaborate como actividades más relevantes para la evaluación, necesitarían un rediseño. Respecto a la primera, las tareas, el reto está en el diseño de tareas de calidad, transferibles y reflexivas (Ibarra-Sáiz et al., 2020), que permitan desarrollar habilidades cognitivas de orden superior y que respondan a una evaluación auténtica (Villarroel & Bruna, 2019), así como una evaluación más personalizada (JISC, 2022; Tai et al., 2023). Respecto a la segunda, el BB Collaborate, se trataría de lograr sesiones más interactivas (Vázquez-Horta, 2021). La existencia de experiencias donde su uso se ha vinculado a la tutorización y la mentoría ha arrojado niveles de satisfacción altos, aunque las limitaciones relativas al acompañamiento emocional persistan y obliguen a revisar los modelos comunicativos (Sánchez & Castro, 2022). Por otra parte, tanto el estudiantado como el profesorado necesitan mayor capacitación digital (Abduh, 2021) pero también evaluativa (Baughan, 2020) para poder dar un mayor empleo formativo tanto a los quizzes (Nehring & Dacey, 2021) como a otras actividades de aprendizaje y evaluación (Gulikers et al., 2010).

En síntesis, los resultados de esta investigación tienen implicaciones a diferentes niveles. Por un lado, ofrecen información para los futuros diseños de docencia híbrida y también de docencia presencial, puesto que hallar el modo de aplicar una evaluación más competencial y en el marco de la evaluación para el aprendizaje apoyada por la tecnología sigue siendo un reto de futuro (Bhagat & Spector, 2017). Además, la apuesta institucional para disponer de infraestructuras y software adecuado pasa a ser un requisito, especialmente vinculado al empleo y valoración que el profesorado realiza de las herramientas a su alcance (Elshami et al., 2021).

Por otra parte, a partir del análisis del grado de uso y utilidad de las diferentes herramientas tecnológicas aplicadas durante el periodo de pandemia, parece clara la necesidad de formación para fortalecer la alfabetización digital y, especialmente, la competencia evaluativa para el desarrollo de propuestas de evaluación formativa en el marco de los LMS (Kruiper et al., 2022). Esta debe no solo centrarse en las herramientas de evaluación digital instrumentalmente sino en propuesta pedagógica que guía el empleo de las funcionalidades de Moodle (Husain, 2021) y en el logro de una evaluación verdaderamente formativa y competencial.

Los resultados mostrados en esta contribución provienen de una limitada muestra participante. La baja representatividad del tamaño de la muestra es común en diseños de recogida de datos online y el propio contexto de emergencia supuso un reto añadido a la llamada a la participación. La segunda limitación por considerar es que los datos recabados son siempre respuesta de variables autopercibidas, de uso declarado de los participantes, por lo que los resultados y conclusiones deben ser tomados con cautela. Por ello, ulteriores estudios serían necesarios para confirmar los datos y/o aumentar la comprensión de la descripción realizada.

El proyecto ha sido financiado por la Universitat de Barcelona. Institut de Desenvolupament Professional (programa REDICE), en el marco del proyecto “Análisis de las prácticas de evaluación en entornos de docencia mixta orientadas al desarrollo de las competencias transversales” (REDICE20-2083).

Laia Lluch-Molins: Curación de datos, Análisis formal, Investigación, Metodología, Software, Visualización, Redacción-borrador original, Redacción-revisión y edición.

Elena Cano-García: Conceptualización, Investigación, Supervisión, Validación, Visualización, Redacción-borrador original, Redacción-revisión y edición.

Todos los autores han leído y están de acuerdo con la versión publicada del manuscrito.

Abduh, M. (2021). Full-time Online Assessment during COVID-19 Lockdown: EFL Teachers’ Perceptions. Asian EFL Journal Research Articles, 28(1.1).

Altinpulluk, H., & Kesim, M. (2021). A systematic review of the tendencies in the use of learning management systems. Turkish Online Journal of Distance Education, 22, 40-54. https://doi.org/10.17718/tojde.961812

Balderas, A., De-La-Fuente-Valentin, L., Ortega-Gomez, M., Dodero, J. M., & Burgos, D. (2018). Learning management systems activity records for students’ assessment of generic skills. IEEE Access, 6, 15958-15968. https://doi.org/10.1109/ACCESS.2018.2816987

Baughan, P. (2020). On Your Marks: Learner-focused Feedback Practices and Feedback Literacy. Advance in Higher Education.

Bennett, S., Dawson, P., Bearman, M., Molloy, E. K., & Boud, D. J. (2017). How technology shapes assessment design: Findings from a study of university teachers. British Journal of Educational Technology, 48(2), 672-682. https://doi.org/10.1111/bjet.12439

Bhagat, K. K., & Spector, J. M. (2017). Formative Assessment in Complex Problem-Solving Domains: The Emerging Role of Assessment Technologies. Journal of Educational Technology & Society, 20(4), 312-317.

Biggs, J., & Tang, C. (2003). Teaching for quality learning at university: What the student does. The Society for Research into Higher Education and Open University Press.

Cano, E. (2019). Presentación del monográfico: Evaluación por Competencias en la Educación Superior: Buenas Prácticas ante los Actuales Retos. Revista Iberoamericana de Evaluación Educativa, 12(2), 5-8. https://doi.org/10.15366/riee2019.12.2.003

Cano, E., & Ion, G. (2012). Assessment practices at Catalan Universities: Towards a competencies-based model. Estudios Sobre Educación, 22, 155-177. https://doi.org/10.15581/004.22.2077

Cañadas, L. (2020). Evaluación formativa en el contexto universitario: Oportunidades y propuestas de actuación. Revista Digital de Investigación en Docencia Universitaria, 14(2), e1214. https://doi.org/10.19083/10.19083/ridu.2020.1214

Carless, D., & Boud, D. (2018). The development of student feedback literacy: Enabling uptake of feedback. Assessment and Evaluation in Higher Education, 43(8), 1315-1325. https://doi.org/10.1080/02602938.2018.1463354

Casal Otero, L., & García Antelo, B. (2018). Una experiencia de formación del profesorado para implementar la evaluación entre pares en el campus virtual de la Universidad de Santiago de Compostela. Pixel-Bit. Revista De Medios Y Educación, (54), 125-144. https://doi.org/10.12795/pixelbit.2019.i54.07

De Miguel, M. (Dir). (2008). Modalidades de enseñanza centradas en el desarrollo de competencias. Orientaciones para promover el cambio metodológico en el EEES. MEC/Universidad de Oviedo. https://d66z.short.gy/6lLsnT

Elshami, W., Taha, M. H., Abuzaid, M., Saravanan, C., Al Kawas, S., & Abdalla, M. E. (2021). Satisfaction with online learning in the new normal: perspective of students and faculty at medical and health sciences colleges. Medical Education Online, 26(1), 1920090. https://doi.org/10.1080/10872981.2021.1920090

Gamage, S. H. P. W., Ayres, J. R., & Behrend, M. B. (2022). A systematic review on trends in using Moodle for teaching and learning. International Journal of STEM Education, 9, 9. https://doi.org/10.1186/s40594-021-00323-x

García-Peñalvo, F. J., Corell, A., Abella-García, V., & Grande, M. (2020). Online assessment in higher education in the time of COVID-19. Education in the Knowledge Society, 21, 12. https://doi.org/10.14201/eks.23013

Gargallo-López, B., García-García, F. J., López-Francés, I., Jiménez Rodríguez, M. Á., & Moreno Navarro, S. (2020). La competencia aprender a aprender: valoración de un modelo teórico. Revista Española de Pedagogía, 78(276), 187-211. https://doi.org/10.22550/REP78-2-2020-05

Gillis, A., & Krull, L. M. (2020). COVID-19 Remote Learning Transition in Spring 2020: Class Structures, Student Perceptions, and Inequality in College Courses. Teaching Sociology, 48(4), 283-299. https://doi.org/10.1177/0092055X20954263

Grande-de-Prado, M., García-Peñalvo, F. J., Corell-Almuzara, A., & Abella-García, V. (2021). Evaluación en Educación Superior durante la pandemia de la COVID-19. Campus Virtuales, 10(1), 49-58.

Gros, B. (2018). La evolución del e-learning: del aula virtual a la red. RIED. Revista Iberoamericana de Educación a Distancia, 21(2), 69-82. https://doi.org/10.5944/ried.21.2.20577

Gulikers, J. T. M., Baartman, L. K. J., & Biemans, H. J. A. (2010). Facilitating Evaluations of Innovative, Competence-Based Assessments: Creating Understanding and Involving Multiple Stakeholders. Evaluation and Program Planning, 33(2), 120-127. https://doi.org/10.1016/j.evalprogplan.2009.07.002

Harper, R., Bretag, T., & Rundle, K. (2020). Detecting contract cheating: examining the role of assessment type. Higher Education Research & Development, 40(2), 263-278. https://doi.org/10.1080/07294360.2020.1724899

Heitink, M. C., Van der Kleij, F. M., Veldkamp, B. P., Schildkamp, K., & Kippers, W. B. (2016). A systematic review of prerequisites for implementing assessment for learning in classroom practice. Educational Research Review, 17, 50-62. https://doi.org/10.1016/j.edurev.2015.12.002

Hettiarachchi, S., Damayanthi, B., Heenkenda, S., Dissanayake, D., Ranagalage, M., & Ananda, L. (2021). Student Satisfaction with Online Learning during the COVID-19 Pandemic: A Study at State Universities in Sri Lanka. Sustainability, 13(21), 11749. https://doi.org/10.3390/su132111749

Husain, F. (2021). Digital Assessment Literacy: The Need of Online Assessment Literacy and Online Assessment Literate Educators. International Education Studies, 14(10), 65-76. https://doi.org/10.5539/ies.v14n10p65

Ibarra-Sáiz, M. S., Rodríguez-Gómez, G., & Boud, D. (2020). The quality of assessment tasks as a determinant of learning. Assessment and Evaluation in Higher Education, 46(6), 943-955. https://doi.org/10.1080/02602938.2020.1828268

JISC. (2022). Guide of principles of good assessment and feedback. JISC. https://d66z.short.gy/mgSHFP

Joia, L. A., & Lorenzo, M. (2021). Zoom In, Zoom Out: The Impact of the COVID-19 Pandemic in the Classroom. Sustainability, 13, 2531. https://doi.org/10.3390/su13052531

Kruiper, S., Martijn, A., Leenknecht, J. M., & Slof, B. (2022). Using Scaffolding Strategies to Improve Formative Assessment Practice in Higher Education. Assessment & Evaluation in Higher Education 47(3), 458-76. https://doi.org/10.1080/02602938.2021.1927981

Kumar, R. (2020). Assessing Higher Education in the COVID19. Brock Education. A journal of educational research and practice, 29(2) 37-41. https://doi.org/10.26522/brocked.v29i2.841

León-Gómez, A., Gil-Fernández, R., & Calderón-Garrido, D. (2021). Influence of COVID on the educational use of Social Media by students of Teaching Degrees. Education in the Knowledge Society, 22, e23623. https://doi.org/10.14201/eks.23623

Llorente, Y., Llovera, J. J., & Serra, R. (2022). Propuesta didáctica para el montaje y gestión de prácticas de laboratorio de física en modalidad e-learning empleando la plataforma Moodle. Referencia Pedagógica, 10, 117-128.

Lluch, L., Halbaut, L., & Cano, E. (2021). Herramientas online para la evaluación de competencias transversales en el Grado de Farmacia en contextos de docencia híbrida. En Research, technology and best practices in Education. EDUNOVATIC2021 – EDITED VOLUME (pp. 482-488). Editorial Adaya Press.

López-Pastor, V., & Sicilia-Camacho, A. (2017). Formative and shared assessment in higher education. Lessons learned and challenges for the future. Assessment and Evaluation in Higher Education, 42(1), 77-97. https://doi.org/10.1080/02602938.2015.1083535

Maier, W., Wolf, N., & Randler, C. (2016). Effects of a computer-assisted formative assessment intervention based on multipletier diagnostic items and different feedback types. Computers & Education, 95, 85-98. https://doi.org/10.1016/j.compedu.2015.12.002

Maldonado, G. A., & Vega, E. M. (2015). Actitud de los estudiantes universitarios ante la plataforma moodle. Pixel-Bit. Revista de Medios y Educación, (47), 105-117. https://doi.org/10.12795/pixelbit.2015.i47.07

McLean, H. (2018). This is the way to teach: Insights from academics and students about assessment that supports learning. Assessment and Evaluation in Higher Education, 43(8), 1228-1240. https://doi.org/10.1080/02602938.2018.1446508

Mellar, H., Peytcheva-Forsyth, R., Kocdar, S., Karadeniz, A., & Yovkova, B. (2018). Addressing cheating in e-assessment using student authentication and authorship checking systems: Teachers’ perspectives. International Journal for Educational Integrity, 14, 2. https://doi.org/10.1007/s40979-018-0025-x

Miranda, L. F., Sánchez Buitrago, J. O., & Viloria, J. (2021). Environmental Sustainability in Higher Education: Mapping the Field. Revista Electrónica de Investigación Educativa, 23, e09. https://doi.org/10.24320/redie.2021.23.e09.4053

Mirza, H. S. (2021). University Teachers’ Perceptions of Online Assessment during the Covid-19 Pandemic in Lebanon. American Academic & Scholarly Research Journal, 13(1), 15. https://doi.org/10.5539/elt.v15n5p94

Molenaar, I., Horvers, A., & Dijkstra, R. (2019). Young Learners’ Regulation of Practice Behavior in Adaptive Learning Technologies. Frontiers in Psychology, 10, 2792. https://doi.org/10.3389/fpsyg.2019.02792

Nehring, N., & Dacey, S. (2021). Formative vs Summative Quizzes as Regular Feedback on Moodle in Computer Science Courses: Which do Students Prefer? Unitec ePress Occasional and Discussion Papers Series. https://doi.org/10.34074/ocds.090

Noorbehbahani, F., Mohammadi, A., & Aminazadeh, M. (2022). A systematic review of research on cheating in online exams from 2010 to 2021. Education and Information Technologies, 27, 8413-8460. https://doi.org/10.1007/s10639-022-10927-7

Pinto, M., & Leite, C. (2020). Digital technologies in support of students learning in higher education: Literature review. Digital Education Review, 37, 343-360. https://doi.org/10.1344/DER.2020.37.343-360

Poth, C. (2018). The contributions of mixed insights to advancing technology-enhanced formative assessments within higher education learning environments: An illustrative example. International Journal of Educational Technology in Higher Education, 15, 9. https://doi.org/10.1186/s41239-018-0090-5

Ross, S. (2019). Slack It to Me: Complementing LMS With Student-Centric Communications for the Millennial/Post-Millennial Student. Journal of Marketing Education, 41(2) 91-108. https://doi.org/10.1177/0273475319833113

Sáiz-Manzanares, M., Casanova, J., Lencastre, J., Almeida, L., & Martín-Antón, L. (2022). Student satisfaction with online teaching in times of COVID-19. Comunicar, 70, 35-45. https://doi.org/10.3916/C70-2022-03

Sánchez, M., & Castro, A. (2022). Mentorías para profesorado universitario ante la Covid-19: Evaluación de un caso. Campus Virtuales, 11(1), 181-200. https://doi.org/10.54988/cv.2022.1.1000

Schweighofer, J., Taraghi, B., & Ebner, M. (2019). Development of a Quiz Implementation of a (Self)Assessment Tool and its Integration in Moodle. International Journal of Emerging Technologies in Learning (iJET), 14(23), 141-151. https://doi.org/10.3991/ijet.v14i23.11484

Tai, J., Ajjawi, R., Bearman, M., Boud, D., Dawson, P., & Jorre de St Jorre, T. (2023). Assessment for inclusion: Rethinking contemporary strategies in assessment design. Higher Education Research & Development, 42(2), 483-497. https://doi.org/10.1080/07294360.2022.2057451

Torrano Montalvo, F., & González Torres, M. C. (2017). El aprendizaje autorregulado: Presente y futuro de la investigación. Electronic Journal of Research in Education Psychology, 2(3). https://doi.org/10.25115/ejrep.3.120

UNESCO (2020). COVID-19 response – Remote learning strategy: remote learning strategy as a key element in ensuring continued learning. UNESCO. https://d66z.short.gy/cn4CJo

Universitat de Barcelona (2008). Competències transversals de la UB. Barcelona: Vicerectorat de Política Docent de la UB. https://d66z.short.gy/WElbKf

Vaganova, O., Smirnova, Z., Vezetiu, E., Chelnokova, E., & Kutepov, M. (2020). Assessment tools in e-learning Moodle. International Journal of Advanced Trends in Computer Science and Engineering, 9(3), 2488-2492. https://doi.org/10.30534/ijatcse/2020/01932020

Vázquez-Horta, F. (2021). Competencias de enseñanza combinada en el posgrado mediante Moodle. Revista Iberoamericana de Investigación en Educación, 1(1). 88-99.

Villa, A. (2020). Competence-based learning: development and implementation in the university field. REDU. Revista de Docencia Universitaria, 18(1), 19-46. https://doi.org/10.4995/redu.2020.13015

Villarroel, V., & Bruna, D. (2019). ¿Evaluamos lo que realmente importa? El desafío de la evaluación auténtica en educación superior. Calidad en la Educación, 50, 492-509. https://doi.org/10.31619/caledu.n50.729

Winstone, N. E., & Boud, D. (2019). Developing Assessment Feedback: From Occasional Survey to Everyday Practice. In S. Lygo-Baker, I. M. Kinchin, & N. E. Winstone (Eds.), Engaging Student Voices in Higher Education (pp. 109-123). Springer International Publishing. https://doi.org/10.1007/978-3-030-20824-0_7

Winstone, N. E., Nash, R. A., Parker, M., & Rowntree, J. (2017). Supporting Learners’ Agentic Engagement with Feedback: A Systematic Review and a Taxonomy of Recipience Processes. Educational Psychologist, 52(1), 17-37. https://doi.org/10.1080/00461520.2016.1207538

_______________________________

(*) Autor de correspondencia / Corresponding author